在手机继续浏览本文,也可以分享给你的联系人。

在手机继续浏览本文,也可以分享给你的联系人。

[新智元导读]《经济学人》1月5日发表万字长文,回顾了机器语言技术长达60多年的发展历程,全文分为五个部分:人机对话、语音识别、机器翻译、语义理解和未来展望。文章重点描述了机器语言技术的现状,特别是深度学习带来的进步,比如神经机器翻译系统。作者说道,基于神经翻译系统训练使用的数据集不像基于短语的系统使用的那样大,这给了较小的公司与Google这样的巨头竞争的机会。展望未来,作者说,言语是最典型的人类特征之一,所以很难想象机器可以像人类一样真正地交谈,却不具备超级智能。二者应该是同时出现的。

语言:发出声音

计算机在翻译、语音识别和语音分析上做得比之前好了很多,Greene 说,但是,他们仍然不能理解语言的意义。

“对不起,Dave。我恐怕不能这么做”,在 电影《2001: A Space Odyssey》中,计算机HAL 9000 用冷冰冰的声音说到。它将离开飞船外出巡航的宇航员 Dave Bowman 拒之门外。HAL 对它的同伴(David)的拒绝,让人们产生了对于机器智能的担忧。

电影在1968年播出时,让计算机跟人类进行顺畅的对话就好像人造飞船登上木星一样遥远。自那时起,人类在打造能对话、能用集成的自然语言回答问题的机器上取得了长足的进步。即便如此,人机之间的交流还是很困难的。如果今天再拍一部这样的电影来反映当下的语言技术,对话应该是这样的:“打开舱门,Hal”,“对不起,Dave,我有些不理解你的问题”。“打开舱门,Hal”,“我为你找到了eBay上有关舱门的物品列表,Dave。”

有创造力和真实对话能力,并且能处理意外事件的计算机现在离我们依然很遥远。被问到什么时候才能创造出智能的HAL、终结者或者Roise(三者都是电影中的机器人角色),人工智能研究者只能一笑而过。虽然除了少量的固定任务外,机器语言技术离取代人类还很遥远,但是,至少它们现在已经好到足够引起重视。它们能帮助人类把更多的时间花在那些只有人类可以完成的工作上。人工智能经历了60年的研究,虽然大部分时间都是让人失望的,但是在过去的几年间,确实产生了一些不小的成果,已经与早期先锋科学家们所期待的结果越来越近。

语音识别取得了卓越的进步。机器翻译也是一样,已经从一塌糊涂走到了可用的阶段,至少已经可以理解一段文本的主旨,很快,机器的翻译可能仅需要少量的人为修订。计算机私人助理,比如苹果的Siri,亚马逊的Alexa 和谷歌的Now以及微软的Cortana,现在已经能处理大量的问题,以多种方式进行组织,并以自然的语音给出准确和有用的答案。Alexa 现在甚至能完成 “给我讲个笑话”这样的请求,但是它只是从笑话数据库中寻找答案。计算机本身并没有幽默感。

苹果在2011年推出Siri时,体验效果非常差,所以很多人都放弃了。根据咨询机构Creative Strategies的数据,只有三分之一的智能手机用户会使用私人助理,并且95%的人的使用只是尝试。这些已经之前在使用过程中受挫的用户可能并没有意识到,现在这些程序有了多大的进步。

1966年,John Pierce 在贝尔实验室做研究。他带领团队建造了第一个晶体管和第一个通信卫星,这两件事为他赢得了声望,所以,美国国家科学院委派给他一个任务,对自动语言处理技术的研究做一个报告。在那段时间,学者们承诺,语言的自动翻译要在几年内攻克。

但是后来这个报告的结果却让人震惊。在对机器翻译、语音自动识别近10年的发展进行了综述后,报告得出结论:钱应该用在一些重要的、实际的和相对短期的项目上。换句话说,语言技术的研究的前景被夸大了,并且很难有产出。

宾夕法尼亚大学的语言学教授、语言数据联盟的带头人Mark Liberman说,关于语言技术如何走过寒冬的故事,既包括实用性,也涉及普遍性。在那些“黑暗”的日子中,研究者一般都不指出自己的研究方法,并且用一种很难评估的方法来描述研究成果。但是,从20世纪80年代开始,美国 DARPA的成员 Charles Wayne 鼓励他们尝试另一种方法——通用任务。

一步一步来

研究人员会商定一套共同的做法,无论他们是教计算机语音识别,说话人识别,文本情绪分析,语法分析,语言识别,手写识别或任何其他任务。他们将列出他们旨在改进的指标,共享用于训练他们的软件的数据集,并允许他们的结果由中立的外部人员进行测试。这使得这个过程更加透明。于是,研究资金再次开始涌入,语言技术开始改善,虽然很慢。

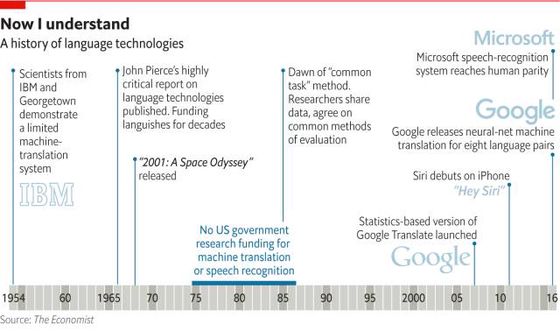

图:语言技术发展史,从1954到2016,来源,经济学人

语言技术的许多早期方法,特别是翻译 ,陷入了一个概念性的死胡同:基于规则的方法。在翻译中,这意味着尝试编写规则来分析原始语言的句子文本,将其分解成一种抽象的“语言”,并根据目标语言的规则重建它。这些方法早期确实表现出了一定的潜力。

但是语言充斥着模糊和异常,所以这样的系统是非常复杂的,并且当对超出它们设计的简单集合的语句进行测试时容易出故障(broke down)。在采纳了统计学的方法,也就是通常被称为“暴力”的方法后,几乎所有的语言技术都开始变得更好了,这依赖于软件搜索大量的数据,寻找模式和从先例学习。例如,在解析语言(将其分解成其语法组件)时,软件从已经被人类解析的大量文本中学习。它使用它学到的东西来对一个以前没见过的文本进行最佳猜测。

在机器翻译中,软件扫描已经由人类翻译的数百万字,再次寻找模式。在语音识别中,软件从记录的主体和人类进行的转录中学习。由于处理器的能力不断增长,数据存储的价格下降,最重要的是,可用数据的爆炸性增长,这种方法最终取得了丰硕成果。

几十年来已知的数学技术开始大显身手,有大量数据的大公司有望受益。那些被像BabelFish 这样的在线工具提供的不当翻译搞得歇嘶底里的人开始对谷歌翻译更有信心。

苹果说服了数百万 iPhone 用户不仅通过手机对话,而且对手机说话。大约5年前,随着深度神经网络(DNN)和深度学习的出现,他们开始取得突破。这种网络经常被吹捧为具有与人类大脑类似的特性:软件中的“神经元”是相互连接的,并且在学习过程,这种连接可以变得更强或更弱。

但是 Nuance 公司研究主管 Nils Lenke说,事实上“DNN只是另一种数学模型”,其基础几十年前就已经奠定。真正改变的是硬件条件。

几乎是偶然地,DNN 研究人员发现,用于在诸如视频游戏的应用中流畅地渲染图形的图形处理单元(GPU)也在处理神经网络方面非常有效。在计算机图形学中,基本的小形状根据相当简单的规则移动,但是有很多形状和许多规则,需要大量的简单计算。相同的GPU用于微调分配给DNN中的“神经元”的权重,因为它们搜索数据来学习。

该技术已经极大地提升了各种深度学习的质量,包括手写识别,人脸识别和图像分类。现在他们正在帮助改进各种语言技术,通常能带来高达30%的提升。这已经将语言技术从零星的使用,变为真正很好的技术。但到目前为止,还没有人完成从好到“可信赖的最好”的转变。

语音识别:我能听懂你

在理解人类的语音上,计算机取得了长足的进步

当人说话时,空气通过肺部,使得声带振动,其通过空气发出特征波形。声音的特征取决于发音器官的位置,特别是舌头和嘴唇的位置,并且声音的特征性质来自某些频率的能量峰值。元音有称为“共振峰”的频率,其中两个频率通常足以区分一个元音与另一个元音。例如,英语单词“fleece”中的元音在300Hz和3000Hz处具有其前两个共振峰。辅音有自己的特征。

理论上,将这种声音流转换成转录的语音是很简单的。与其他语言技术一样,识别语音的机器根据先前收集的数据进行训练。在这种情况下,训练数据是由人类转录文本的声音记录,使得软件同时拥有声音和文本输入,所有它要做的是对二者进行匹配。

机器在处理如何以与人类在训练数据中相同的方式转录给定的声音块上变得更好。传统的匹配方法是一种称为隐马尔科夫模型(HMM)的统计技术,主要是基于机器之前做的工作进行猜测。最近,语音识别也从深度学习中获益良多。

英语有约44个“音素”,组成语言的声音系统的单位。 P和b是不同的音素,因为它们用于区分诸如pat和bat的词。“p ”的发音有时候是送气的,如在“party”一次中,p有时候又不送气,如在“spin”中 。如果计算机听到音素s,p,i和n相继出现,它应该能够识别出是词“spin”。

但是现场演讲的对于机器来说很困难。因为声音不是单独发音,一个音素接着另一个,它们大多是在一个恒定的流,找到边界不容易。音素也根据上下文而不同。 并且,扬声器在音色和音高以及重音方面不同。对话远不如仔细听写清晰。人们在说话的过程中的停顿比他们意识到的更频繁。

所有这一切,技术已经逐渐克服了许多这类问题,因此语音识别软件的错误率多年来稳步下降,然后随着深度学习的引入急剧下降。麦克风已经更好,更便宜。随着无处不在的无线互联网,语音记录可以轻松地传送到云中的计算机进行分析,甚至智能手机现在都经常有足够的计算能力来执行这项任务。

同义词识别:Bear arms or bare arms?

也许语音识别系统最重要的特征是它对某人可能会说什么或其“语言模型”的预期。与其他训练数据一样,语言模型基于大量真实的人类言语,并转录成文本。当语音识别系统“听到”声音流时,它对所说的内容做出许多猜测,然后基于它所具有的单词,短语和句子的种类来计算它找到正确的、此前见过的训练文本的几率。

在音素级别,每种语言都有允许或者禁止的字符串 。同样的话语。一些字符串比其他更常见。 在做出关于同音词的猜测时,计算机将会记住在其训练数据中,短语“拥有武器的权利”(the right to bear arms)比“裸露手臂的权利”(the right to bare arms)出现得多,因此将做出正确的猜测。

根据特定说话者进行训练大大减少了软件的猜测工作。对于那些愿意更长时间地训练软件的人,可以获得接近99%的准确性(意味着每一百个单词的文本,被错误地添加,省略或改变的不超过1个)。一个好的麦克风和一个安静的房间会更有效。

提前知道说话者可能谈论什么样的事情也会增加准确性。像“静脉炎”和“胃肠道”这样的词在一般话语中不常见。但是这些词在医学中是常见的,因此创建经过训练以查找这些词的软件会明显改善结果。

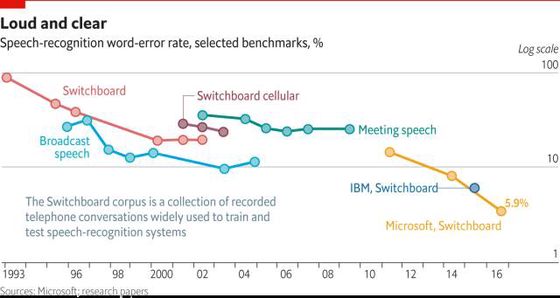

与所有其他语言技术领域一样,深度学习大大降低了错误率。2016年10月,微软宣布,其最新的语音识别系统已经与人类速记员在识别 Switchboard Corpus中的语音上达到相同水平。

Switchboard Corpus 的错误率是一个广泛使用的基准,因此可以与其他的质量改进声明进行比较。十五年前,语音识别质量停滞不前,错误率为20-30%。微软的最新系统,有六个神经网络并行运行,错误率已降到5.9%,与人类转录的相同。微软首席演讲科学家黄学东表示,他原本的预计是,还需要两三年才能达到人类水平。

实验室的进步现在正应用于现实世界的产品中。越来越多的汽车配备有各种声控的控制,但是所涉及的词汇有限,这确保了高精度。麦克风或者通常具有窄拾音区域的麦克风阵列在识别组中的相关说话者方面越来越好。

一些问题仍然存在。儿童和老人说话者,以及在房间里移动的人,在识别上是困难的。背景噪声仍然是一个大问题,如果它与训练数据中的不同,软件则很难进行识别。例如,微软为企业提供了一个称为CRIS的产品,允许用户为背景噪声,特殊词汇和其他在特定环境中遇到的特别语音识别系统。这可能是有用的。

但是对于一台计算机来说,知道一个人所说的只是一个开始。两者之间顺畅的交互,也就是在几乎每个科幻故事中出现的那种,需要能够说话的机器。

机器翻译:超越巴别塔

计算机翻译变得惊人的好,但仍需要人类的输入。

在《星际旅行》中,有“宇宙翻译器”;在《银河系搭车客指南》中,有可以方便地进入耳朵的“巴别鱼”(Babel Fish)。科幻故事中,那些来自遥远文明的人们相遇时自然需要某种设备来让他们能够交谈。高质量的自动翻译技术似乎比其他语言技术更加神奇,因为对许多人来说,学习一种以上的语言已经足够费劲,更别说把一种语言翻译为另一种语言。

这个想法从20世纪50年代以来一直存在,计算机翻译也一直作为新奇的“机器翻译”(MT)为人所知。这个概念可以追溯到冷战时期,当时美国科学家试图让计算机将俄语翻译为英语。他们的灵感来自第二次世界大战的代码破解的成功,这带来了计算机技术的发展。对他们来说,在俄语文本里的西里尔字母只是英语的编码版本,把它变成英语只是一个解码的问题。

IBM和乔治城大学的科学家都认为这个问题很快就能破解。他们在计算机上编写了六个规则和一个250个词汇的词汇表,于1954年1月7日在纽约进行了一次演示,并自豪地宣称已经成功完成60个俄语句子的自动翻译,包括“Mi pyeryedayem mislyi posryedstvom ryechyi”,这句话被正确地翻译为“ 我们通过讲话传达思想。”乔治城大学的Leon Dostert是这个项目的首席科学家,他大胆地预测三到五年内,机器翻译将完全实现,而且将是“一个完美的事实”。

然而,经过十多年的研究,1966年由John Pierce主持的一个委员会会议发表了一份报告,报告的导言中提到,机器翻译的结果令人失望,并敦促研究人员集中精力于狭义的,可实现的目标,如自动化词典 。政府赞助的MT研究开始进入冬眠,并持续了将近二十年。这期间的一切研究工作都是由私人公司支持进行的。其中最引人注目的是Systran系统翻译软件,它主要为美军提供粗略的翻译。

科学家们发现基于规则的机器翻译方法陷入困境。在他们继续完善这个6条规则的系统之后,他们相信如果他们把更多的规则编程给计算机,翻译系统将能变得更加复杂和准确。然而事与愿违,系统翻译的内容出现更多无意义的句子。添加额外的规则,用现在的软件开发人员的话来说,是没有“扩展”。

除了编程中大量的语法规则和例外带来的困难,一些早期的观察者注意到一个概念上的问题。即一个单词的含义通常不仅取决于其字典定义和上下文语法,而且取决于句子其余部分的含义。以色列MT领域的先导Yehoshua Bar-Hillel注意到“the pen is in the box”和“the box is in the pen”这两句话中,“pen”的翻译应该是不同的:能够装下“盒子”的“pen”应该是“围栏”,而不是“钢笔”。

怎样教给机器足够多的规则来进行这种区分?这要求机器要有一些关于真实世界的知识,但这远远超出了机器或者当时的程序员的能力。二十年后,IBM的科学家偶然发现了一种可以恢复对MT的乐观态度的方法。IBM的Candide系统是第一次使用统计概率而非人为制定的规则进行机器翻译的尝试。统计是“基于短语”的机器翻译,像语音识别一样,需要用来学习的训练数据。 Candide使用加拿大的《国会议事录》作为训练数据,这是用法语和英语出版该国议会辩论,为当时的统计翻译提供了大量的数据。基于短语的方法能够确保单词的翻译适当地考虑周围的单词。